Les Friendly Hackers de Thales inventent un métamodèle de détection des images réalisées par IA (deepfakes)

Les Friendly Hackers de Thales inventent un métamodèle de détection des images réalisées par IA (deepfakes)

- Après avoir remporté l’édition 2023 du Challenge organisé par l’AID (Agence de l’Innovation de Défense), l’équipe Friendly Hackers de Thales s’illustre une nouvelle fois en 2024, et ce, grâce à une technologie particulièrement ingénieuse, un métamodèle de détection des images générées par IA (les deepfakes).

- Le métamodèle de Thales est construit sur une agrégation de modèles attribuant chacun un score d’authenticité à chaque image.

- Ces contenus (images, vidéos et audios) créés artificiellement par une IA font l’objet d’un usage croissant à des fins de désinformation mais aussi de manipulation et de fraude à l’identité.

MEUDON, France--(BUSINESS WIRE)--A l’occasion de la European Cyber Week qui se tient à Rennes du 19 au 21 novembre 2024, dont la thématique centrale est celle de l’intelligence artificielle, les équipes de Thales ont participé au Challenge de l’AID en s’illustrant à la deuxième place grâce au développement d’un métamodèle de détection des images générées par IA. A l’heure où la désinformation gagne les médias et tous les secteurs de l’économie, à l’aune de la généralisation des techniques d’IA, cet outil vise à lutter contre la manipulation d’image et ce, pour différents cas d’usage comme celui de la lutte contre la fraude à l’identité.

Les images générées par IA le sont grâce à l’utilisation de plateformes IA modernes (Midjourney, Dall-E, Firefly, etc.). Aujourd’hui, les technologies d’IA ont tellement évolué qu’il devient quasiment impossible à l’oeil nu de distinguer une image réelle d’une image générée par IA. Cela s’applique également à la vidéo, et ce, même en temps réel. Une image générée par IA peut donc constituer une porte ouverte pour des attaquants malveillants pouvant l’utiliser à des fins d’usurpation d’identité et de fraudes. Certaines études prévoient que d’ici quelques années, les deepfakes pourraient causer des pertes financières massives en raison de leur usage à des fins d’usurpation d’identité et de fraude. Le cabinet Gartner a estimé qu’en 2023, environ 20 % des cyberattaques pourraient inclure des contenus deepfake dans le cadre de campagnes de désinformation ou de manipulation. Leur rapport1 met en évidence la hausse des deepfakes dans la fraude financière et les attaques de phishing avancées.

« Le métamodèle de Thales de détection des deepfakes répond notamment à la problématique de la fraude à l’identité et à la technique de morphing2. L’agrégation de plusieurs méthodes utilisant les réseaux de neurones, la détection du bruit ou encore les fréquences spatiales permettra de mieux sécuriser les solutions de plus en plus nombreuses nécessitant la vérification d’identité par reconnaissance biométrique. Il s’agit d’une avancée technologique remarquable, issue de l’expertise des chercheurs en IA de Thales. » précise Christophe Meyer, Expert Senior en IA et Directeur Technique au sein de cortAIx, l’accélérateur d’IA de Thales.

Le métamodèle de Thales se nourrit des techniques de machine learning, d’arbres de décisions, et d’évaluation des forces et des faiblesses de chaque modèle afin d’analyser l’authenticité d’une image. Il agrège ainsi différents modèles, parmi lesquels :

- La méthode CLIP (Contrastive Language–Image Pre-training) qui consiste à relier des images et du texte en apprenant à comprendre comment une image et sa description textuelle se correspondent. En d’autres termes, CLIP apprend à associer des éléments visuels (comme une photo) avec des mots qui les décrivent. Pour détecter les deepfakes, CLIP peut analyser des images et évaluer leur compatibilité avec des descriptions sous format texte repérant ainsi les incohérences ou anomalies visuelles.

- La méthode DNF qui utilise les architectures actuelles de génération d’images (les modèle de « diffusion ») pour détecter celles-ci. Concrètement, les modèles de diffusion sont basés sur l’estimation d’un bruit à ajouter à une image pour créer une « hallucination » qui va créer du contenu à partir de rien. L’estimation de ce bruit peut aussi être utilisée dans la détection des images générées par IA.

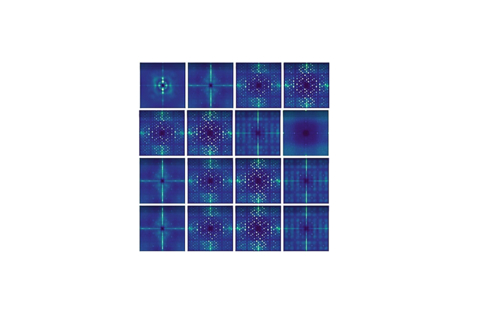

- La méthode DCT (Discrete Cosine Transform) repose sur l’analyse des fréquences spatiales d’une image. En transformant l’image de l’espace spatial (pixels) vers l’espace des fréquences (comme les ondes), le DCT permet de déceler des anomalies subtiles dans la structure de l’image, souvent invisibles à l’œil nu. Elles apparaissent lors de la génération de deepfakes.

L’équipe de Friendly Hackers à l’origine de cette invention fait partie de cortAIx, l’accélérateur d’IA de Thales, comptant plus de 600 chercheurs et ingénieurs en IA dont 150 basés sur le plateau de Saclay et intervenant sur des systèmes critiques. Les Friendly Hackers du Groupe ont développé une boite à outils, la BattleBox, dont l’objectif est de faciliter l’évaluation de la robustesse des systèmes intégrant de l’IA contre les attaques visant à exploiter les vulnérabilités intrinsèques des différents modèles de d’IA (incluant les Large Language Models), tels que les attaques adverses ou les attaques visant l’extraction des informations sensibles. Pour faire face aux attaques, des contremesures adaptées, telles que le désapprentissage, l’apprentissage fédéré, le tatouage de modèle, la robustification des modèles sont proposées.

Le Groupe a été lauréat en 2023 dans le cadre du challenge CAID (Conference on Artificial Intelligence for Defense) organisé par la DGA, visant à retrouver certaines données utilisées pour entraîner une IA, y compris alors que celles-ci avaient été effacées du système pour préserver leur confidentialité.

A propos de Thales

Thales (Euronext Paris: HO) est un leader mondial des hautes technologies spécialisé dans trois secteurs d’activité : Défense & Sécurité, Aéronautique & Spatial, et Cybersécurité & Identité numérique.

Il développe des produits et solutions qui contribuent à un monde plus sûr, plus respectueux de l’environnement et plus inclusif.

Le Groupe investit près de 4 milliards d’euros par an en Recherche & Développement, notamment dans des domaines clés de l’innovation tels que l’IA, la cybersécurité, le quantique, les technologies du cloud et la 6G.

Thales compte près de 81 000 collaborateurs dans 68 pays. En 2023, le Groupe a réalisé un chiffre d'affaires de 18,4 milliards d'euros.

EN SAVOIR PLUS

Développer une IA vraiment digne de confiance | Thales Group

1 2023 Gartner® Report on Emerging Cybersecurity Risks

2 Technique consistant à transformer progressivement un visage en un autre par étapes successives, en modifiant des traits visuels pour aboutir à un portrait réaliste entre les deux apparences.

Contacts

Marion Bonnet

Thales PR Manager

Marion.bonnet@thalesgroup.com

+33660384892