阿聯阿布達比--(BUSINESS WIRE)--(美國商業資訊)-- 技術創新研究所(TII)是全球首屈一指的科研中心和阿布達比先進技術研究理事會(ATRC)的應用研究支柱。該研究所發布了Falcon系列中的一款新的大型語言機型——Falcon Mamba 7B。經Hugging Face獨立驗證,新模型是全球效能第一的開放原始碼狀態空間語言模型(SSLM)。

身為Falcon系列的首款SSLM,它有別於之前所有使用Transformer架構的Falcon模型。新的Falcon Mamba 7B模型是該研究所正在進行的開創性研究及其以開放原始碼形式向社群提供突破性工具和產品的又一例證。

ATRC秘書長兼阿聯總統策略研究和先進技術事務顧問Faisal Al Bannai閣下表示:「Falcon Mamba 7B代表TII連續第四次獲得人工智慧模型排名第一,鞏固了阿布達比作為全球人工智慧研發中心的地位。這一成就彰顯了阿聯對創新的堅定承諾。」

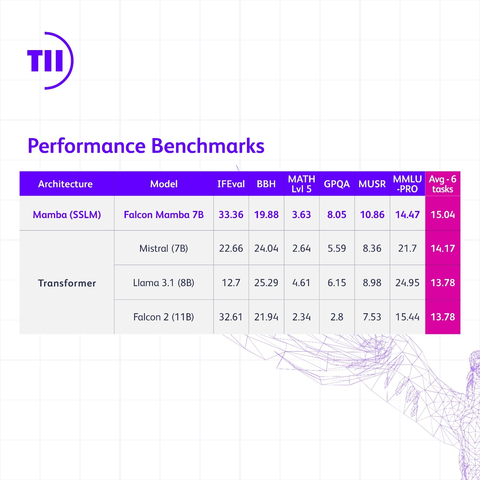

在Transformer架構模型方面,Falcon Mamba 7B在HuggingFace新引進的基準測試中優於Meta的Llama 3.1 8B、Llama 3 8B和Mistral的7B。同時,在其他SSLM中,Falcon Mamba 7B在舊基準測試中擊敗了所有其他開放原始碼模型,它將成為HuggingFace新的更嚴苛基準測試排行榜上的第一款模型。

TII執行長Najwa Aaraj博士表示:「技術創新研究所繼續透過Falcon系列人工智慧模型突破技術發展的界限。Falcon Mamba 7B代表了真正的開創性工作,為未來的人工智慧創新奠定了基礎,這些創新將強化人類的能力並改善生活。」

狀態空間模型在理解隨時間演變的複雜情況(如一整本書的內容)方面表現極為出色。這是因為SSLM不需要額外的記憶體來消化如此大量的資訊。

另一方面,基於Transformer的模型在記住和使用它們之前處理過的序列資訊方面非常高效。這使它們在內容生成等任務中表現出色,然而,由於它們會將每個單字與其他單字進行比較,這就需要大量的運算能力。

SSLM可應用於各種領域,如估計、預測和控制任務。與Transformer架構模型類似,它們在自然語言處理任務中也有出色表現,可應用于機器翻譯、文本摘要、電腦視覺和音訊處理。

TII人工智慧跨中心部門代理首席研究員Hakim Hacid博士表示:「在推出Falcon Mamba 7B之際,我為TII促進其發展的合作生態系統感到驕傲。這次發布代表我們向前邁出了一大步,啟發了新的視角,進一步推動了對智慧系統的探索。在TII,我們正在突破SSLM和Transformer模型的界限,以激發生成式人工智慧領域的更多創新。」

Falcon LLM的下載次數已超過4500萬次,證明了該模型的巨大成功。Falcon Mamba 7B將基於TII Falcon License 2.0發布。這是一種基於Apache 2.0的寬鬆軟體許可證,包含一項促進人工智慧負責任使用的可接受使用政策。如欲瞭解有關這一新模型的更多資訊,請造訪FalconLLM.TII.ae。

*來源: AETOSWire

免責聲明:本公告之原文版本乃官方授權版本。譯文僅供方便瞭解之用,煩請參照原文,原文版本乃唯一具法律效力之版本。